震林华夏机柜解决方案

一、电源系统解决方案

二、机房制冷

数据中心机房环境对服务器等IT设备正常稳定运行起着决定性作用。数据中心机房建设的国家标准 GB50174-2008《电子信息机房设计规范》对机房开机时的环境的要求:

为使数据中心能达到上述要求,应采用机房专用空调。如果数据中心机房环境不能满足以上要求会对服务器等IT设备造成以下影响:

u 1)温度无法保持恒定 - 造成电子元气件的寿命降低;

u 2)局部温度过热 - 设备突然关机;

u 3)湿度过高 - 产生冷凝水,短路;

u 4)湿度过低 - 产生有破坏性的静电;

u 5)洁净度不够 - 机组内部件过热,腐蚀;

(一)、数据中心热负荷及其计算方法

按照数据中心机房主要热量的来源,分为:

设备热负荷(计算机等IT设备热负荷);l

l 机房照明热负荷;

建筑维护结构热负荷;l

补充的新风热负荷;l

人员的散热负荷等。l

1、机房热负荷计算方法一:各系统累加法

(1)设备热负荷:

Q1=P×η1×η2×η3 (KW)

Q1:计算机设备热负荷

P:机房内各种设备总功耗(KW)

η1:同时使用系数

η2:利用系数

η3:负荷工作均匀系数

通常,η1、η2、η3 取0.6~0.8之间,考虑制冷量的冗余,通常η1×η2×η3取值为0.8。

(2)机房照明热负荷:

Q2=C×S (KW)

C:根据国家标准《计算站场地技术要求》要求,机房照度应大于2001x,其功耗大约为20W/M2。以后的计算中,照明功耗将以20 W/M2为依据计算。

S:机房面积

(3)建筑维护结构热负荷

Q3=K×S/1000 (KW)

K:建筑维护结构热负荷系数(50W/m2机房面积)

S:机房面积

(4)人员的散热负荷:

Q4=P×N/1000 (KW)

N:机房常有人员数量

P:人体发热量,轻体力工作人员热负荷显热与潜热之和,在室温为21℃和24℃时均为130W/人。

(5)新风热负荷计算较为复杂,我们以空调本身的设备余量来平衡,不另外计算。

以上五种热源组成了机房的总热负荷,即机房热负荷Qt= Q1+Q2+ Q3+ Q4。由于上述(3)(4)(5)计算复杂,通常是采用工程查表予以确定。但是因为数据中心的规划与设计阶段,非常难以确定,所以实际在数据中心中通常采用设计估算与事后调整法。

2、机房热负荷计算方法二:设计估算与事后调整法

数据中心机房主要的热负荷来源于设备的发热量及维护结构的热负荷。

因此,要了解主设备的数量及用电情况以确定机房专用空调的容量及配置。根据以往经验,除主要的设备热负荷之外的其他负荷,如机房照明负荷、建筑维护结构负荷、补充的新风负荷、人员的散热负荷等,如不具备精确计算的条件,也可根据机房设备功耗及机房面积,按经验进行测算。

采用“功率及面积法”计算机房热负荷。

Qt=Q1+Q2

其中,Qt 总制冷量(KW)

Q1 室内设备负荷(=设备功率×1.0)

Q2 环境热负荷(=0.12~0.18KW/m2 ×机房面积),南方地区可选0.18,而北方地区通常选择0.12

方法二是对复杂科学计算的工程简化计算方法。这种计算方法下,通常容易出现计算热量大于实际热量的情况,因为机房专用空调自动控制温度并决定运行时间,所以多余的配置可以作为冗余配置,对机房专用空调的效率与耗电量不大。本文以方法二推导数据中心机房专用空调配置与能效计算。

(二)、数据中心机房专用空调配置

设定数据中心的IT类设备为100KW,并且固定不变。根据上述方法二,还需要确定机房的面积。

再假定数据中心的热负荷密度为平均热负荷密度,即4Kw/机柜。也就是说平均每个机柜为4kw的热负荷。

数据中心的机柜数量为:100kw/4kw=25台机柜

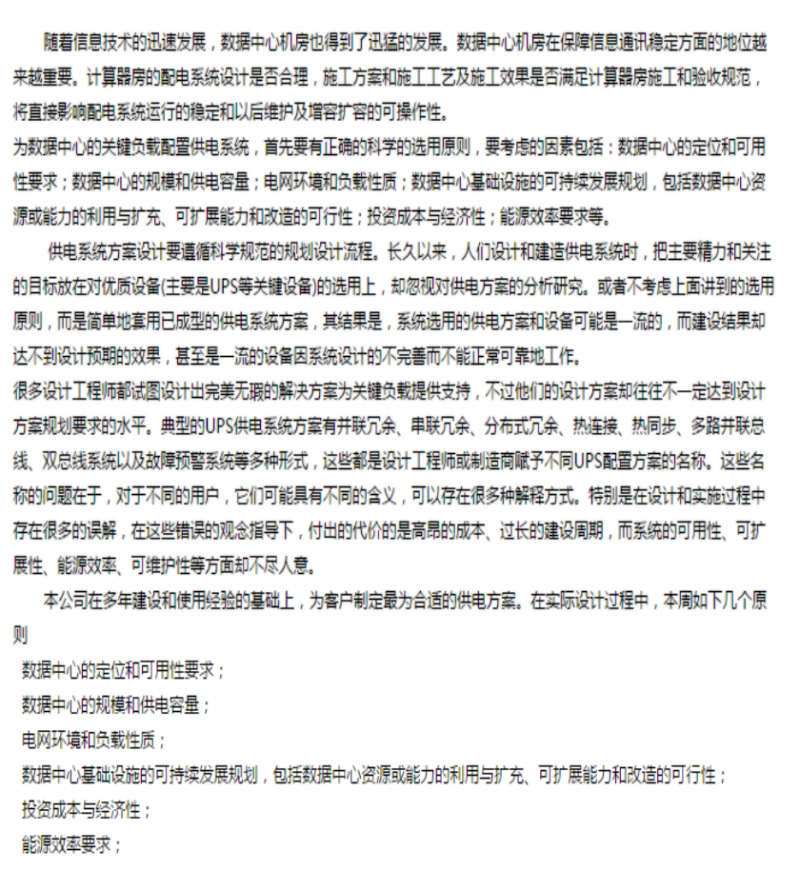

按国家标准 GB50174-2008《电子信息机房设计规范》有关机柜占地面积计算方法,

取每个机柜的占地面积为中间值4m2/台,那么数据中心的面积为:

25台机柜×4m2/台=100 m2

假定环境热负荷系数取0.15 KW/m2,则数据中心机房总热负荷为:

Qt=Q1+Q2=100kw+100×0.15=115kw

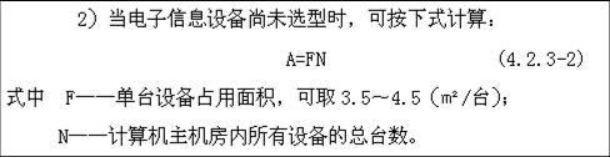

数据中心送风方式选择:按国家标准要求,采用地板下送风,机柜按冷热通道布置。

机房专用空调选择:机房空调通常分为DX(直接制冷)与非直接制冷(包括各类水制冷系统等),先讨论直接制冷系统的机房空调。不同厂家有不同型号的机房专用空调,以艾默生网络能源有限公司生产的Pex系列机房空调为例,应配置的机房空调为:

两台P2060机房空调,在24℃ 相对湿度50%工况下,每台制冷量为60.6kw,两台空调的总制冷量为121.2kw,略大于115kw的计算热负荷。

根据国家标准 GB50174-2008《电子信息机房设计规范》的数据中心空调配置建议,数据中心通常建议采用N+M(M=1,2,…)配置形式,提供工作可靠性与安全性。

假设本数据中心采用N+1方式配置,即为2+1方式配置3台P2060机房空调,实现两用一备工作。

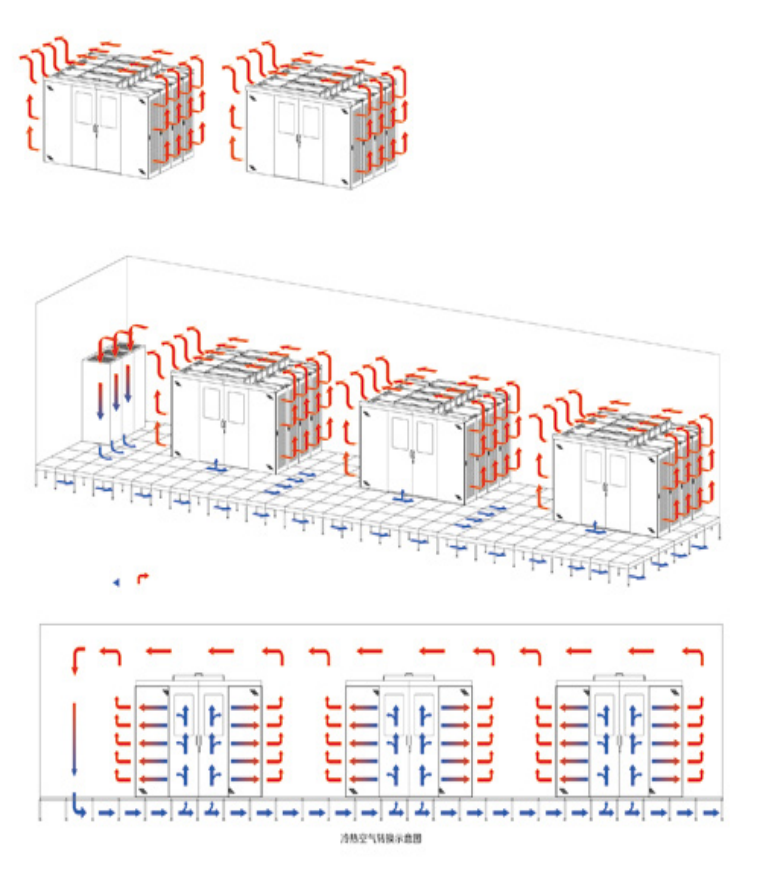

(三)、通过封闭冷通道达到节约能源的目的

传统通信机房现有的上送风空调系统,首先是降低机房的环境温度,然后才能使机柜降温、冷却。所以,机房设备为了保持良好的散热,必须首先有效的降低的外界环境温度。就其效率而然,空调的能量显然有一部分消耗在了降低环境温度上,而不是直接去降低设备的温度。此外采用普通的上送风方式,容易形成局部热岛。增加空调,增加冷量的方式将会消耗过多的电能。

上送风机房受到机房结构和布局的影响,机房内实际气流组织都是比较复杂,气流组织混乱,冷热气混合,容易导致空调冷风会从机柜以上空间,列间过道及机柜的空置区短路流失,导致能量损失,制冷效果都比较低,另外,由于空调系统的冷风基本均匀分配在机房内部的各个区域,冷风无法实现精确分配,在局部设备密度高的区域冷量会分配不够,开成了局部热岛,造成了机房局部过热。随着通信网络设备的功率密度越来越高。特别是数据网络机房,IDC机心内大量使用的IT类设备,其功率密度一般是传统通信机房的数倍至数十倍。在这样的功率密度情况下,内粗犷式的气流组织已经难以满足设备冷却的需求。

经过多年的实践和理论证明,数据中心最佳的风流组织是地板下送风,天花板上回风,精密空调设置单独的设备间,机柜面对面摆放冷热通道隔离并实现冷通道封闭(防止冷气短路)达到节能的效果,示意图如下。

1、冷通道封闭要求做到以下几点:

1)地板安装必须不漏风。只有在冷通道内才能根据负荷大小替换相应的通风地板。通风地板的通风率越大越好,建议采用高通风率地板。不建议使用可调节的通风地板,一是阻力大,二是运维一般做不到这么精细的管理。

2)冷通道前后和上面完全封闭,不能漏风。采用能自动关闭的简易推拉门,在门上安装观察玻璃。机柜前面安装LED节能灯解决冷通道照明问题或冷通道顶部安装LED节能灯解决通道照明(安装红外达到人来灯亮,人走类灭)。

3)机柜前部的冷通道必须封闭,没有安装设备的地方必须安装盲板,机柜两侧的设计不能漏风。机柜如果有前后门,使用六角形孔,通风率不低于75%,风阻要小。如果管理上没有要求,建议机柜尽可能不安装前后门。

4)地板下电缆、各种管道和墙的开口处要求严格封闭,不能漏风。地板上的开口或开孔也都要严格封闭,不能漏风。地板下除消防管道外,尽可能不要安装任何电缆、线槽或管道等,这些干扰物会强烈干扰地板下空间的送风气流分布,增加风阻,使不同机柜中设备的冷却性能不均匀。每个机柜的功率密度低于3KW时建议地板的高度为600mm,功率密度在3到5KW之间地板高度建议800mm,功率密度大于5KW时建议地板高度为1000mm。由于防静电地板的尺寸为600mmX600mm,因此对于单个机柜功率密度小于5KW时的最佳布局是7块地板摆两排机柜,设备对其冷通道。

对于高密度机柜,可以根据功率密度和通风地板的通风率决定8块或9块地板摆放两排机柜,示意图如下。

标准机柜的宽度为600mm,刚好对应一块地板。服务器机柜的长度一般为1000mm到1200mm之间,相应的热通道宽度为1000mm到800mm之间。

4)采用冷通道封闭技术后,整个机房除冷通道外都属于高温区,温度将在30到40℃之间。一年内绝大部分时间的室外空气温度低于机房的热通道温度,因此机房外墙建议不进行保温处理。

2、提高机房温度节约能源

根据中华人民共和国国家标准GB 50174-2008 《电子信息系统机房设计规范》,A类和B类机房的主机房温度要求保持在23±1℃,也就是22到24℃。ANSI/TIA-942-2005《Telecommunications Infrastructure Standard for Data Centers》中规定冷通道温度为华氏68-77度,也就是20到25℃。美国采暖制冷与空调工程师学会(ASHRAE)2008年新的机房冷通道温度已经从2004年的20到25℃提高到18到27℃。

由于国家标准中规定的主机房温度没有指定是机柜前的进风温度,传统机房存在以下两方面不足:

1)由于没有冷通道或热通道封闭,机房温度特别的低,设备内部的温度并不低,大量的冷气短路自循环。

2)机房温度往往低于24℃,处于过度制冷状态。

现代服务器和网络设备等并非传统观念(10年或20年前)中认为的那么娇贵,大部分服务器在温度10-35℃,相对湿度20%-80%都可以正常运行(ASHRAE认为的设备环境要求,也是绝大部分商用服务器的工作环境要求范围)。因此可以提高空调送风温度,保证IT设备的运行温度即可。当空调系统的送风和回风温度提高1℃时,空调系统节电约2.5%。同时空调系统的制冷能力提高约5%。

因此,在用户认可的条件下,提高机房的温度是节约能源的措施之一。建议数据中心冷通道的温度(ASHRAE标准要求在冷通道中间对准机柜中间1.5米高度测量,每4个机柜至少一个测试点)最低为为24或25℃.

3、科学运维节约能源

大型数据中心通过科学运维可以大大提高空调系统的节能效率。常用的科学运维措施包括以下方面。

1)人走关灯和关闭大屏幕显示器,减少照明产生的能耗以及相应增加的制冷量。

2)尽量减少运行新风系统。在机房无人时关闭相应区域的新风系统。

3)建议冷通道的温度不低于25℃。定期检查冷通道的温度以免过度制冷造成能源浪费。

4)定期检查地板,防止各种方式的漏风。

5)冷通道必须完全封闭,机柜上没有设备的区域必须安装盲板,没有负荷的机6)柜区域不能安装通风地板。每次设备变更,都要进行检查。

7)在能够满足制冷的条件下尽可能提高冷冻水的温度,最高为12到18℃。

8)在气象环境满足的条件下,尽量使用全自然或半自然免费制冷。

9)定期核对数字采集数据和模拟显示仪表的数据是否一致,若发现数据存在误差,立即更换有关采集设备或仪表。

10)对于还没有使用的独立机房区域,关闭所有机电设备,包括冷冻水管道的阀门。

11)定期检修和清洗冷冻机组内的铜管和冷却塔,确保其工作在最佳状态。

12)对于低负荷的机房,如果精密空调没有EC风机,就要关闭相应的空调,如果是EC风机,要通过实践摸索出更节能空调运行方式。

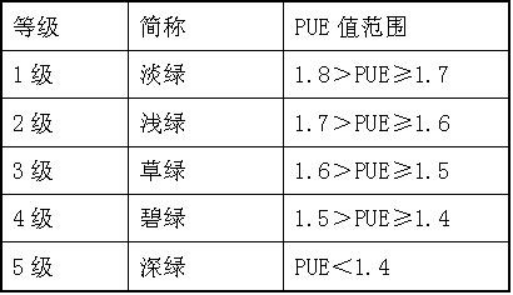

根据相关数据中心的运行数据以及采取上述各种节能措施,在北京建设大型节能数据中心的PUE值是可以达到1.3左右的,其中科学运维是及其重要的。我们建议将绿色数据中心分成以下5个等级。

节能方面计算(只考虑制冷面积)可以简单得出(本节的:二、数据中心机房专用空调配置),机房的总面积为100平方,实际机柜的冷通道面积为27平方(每台机柜约0.6*1.8=1.08平方)

即总热负荷为:100+27*0.15=104.05KW,原为:115KW

如果每台机柜每小时节约0.4度电能,一年可节约3504元,25个机柜一年可节约87600元,如果规模更大节约成本更多。

综合以上,冷通道是解决IDC设备过热和节约能源的最佳解决方案之一。

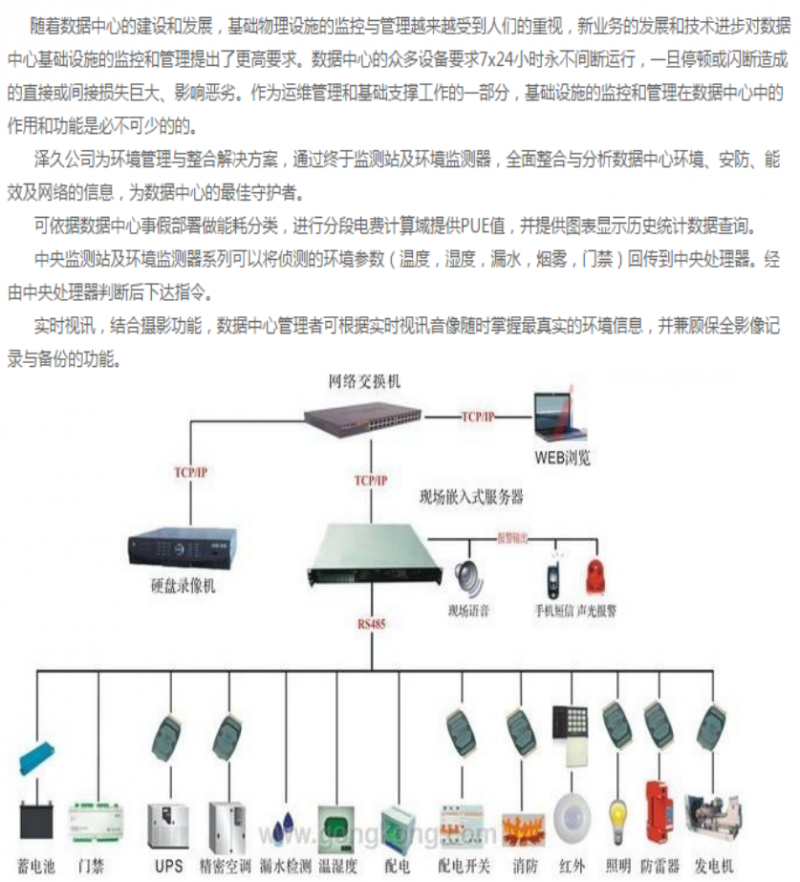

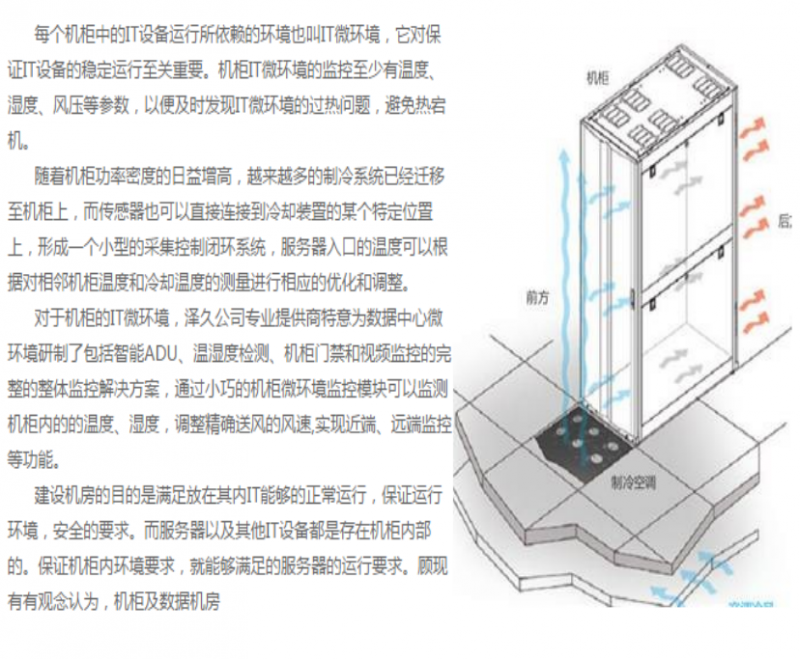

三、环境监测

四、服务内容

(一)、冷通机房构造原理

冷通原理

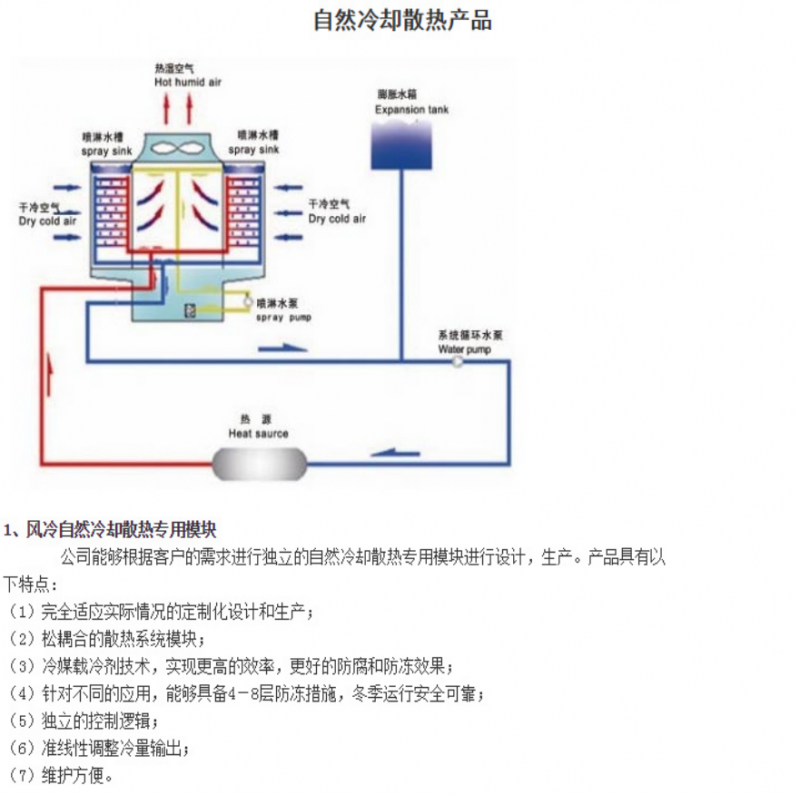

(二)、自然冷却散热产品

五、机柜及配件

六、冷池冷通道

[VIP第11年] 指数:10

[VIP第11年] 指数:10 通过认证

通过认证